大型语言模型的推理能力经常被高估

说到人工智能,外表是会骗人的。大型语言模型 (LLM) 内部运作的神秘性源于其庞大的规模、复杂的训练方法、难以预测的行为和难以捉摸的可解释性。

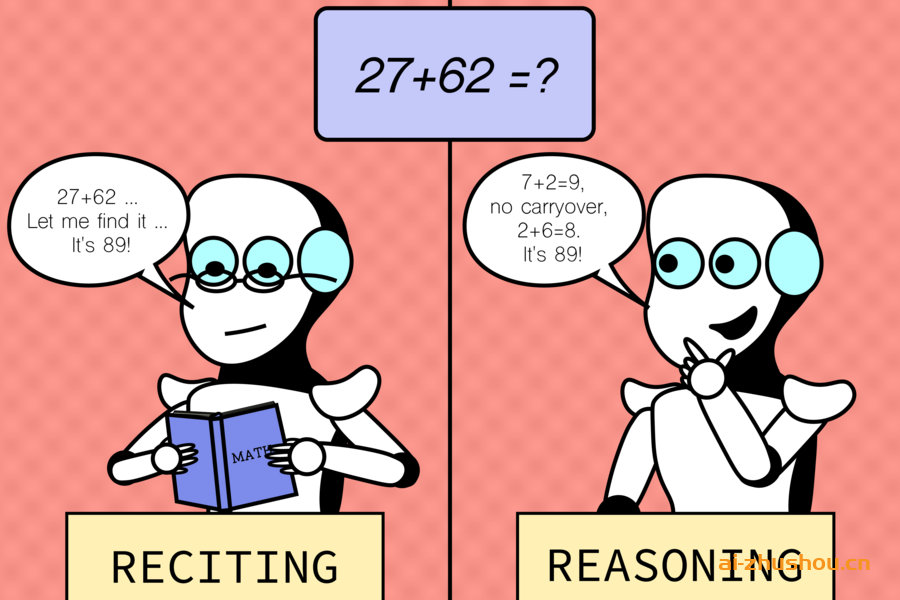

麻省理工学院计算机科学与人工智能实验室 (CSAIL) 的研究人员最近通过放大镜研究了法学硕士在各种不同任务中的表现,揭示了记忆和推理能力之间相互作用的有趣见解。结果表明,他们的推理能力往往被高估了。

该研究将“默认任务”(即模型训练和测试的常见任务)与“反事实场景”(即偏离默认条件的假设情况,通常可以预期 GPT-4 和 Claude 等模型能够应对这些情况)进行了比较。研究人员通过调整现有任务而不是创建全新的任务,在模型的舒适区之外开发了一些测试。他们使用了各种数据集和基准,专门针对模型能力的不同方面量身定制,例如算术、国际象棋、评估代码、回答逻辑问题等。

当用户与语言模型交互时,任何算术通常都是以十进制为基数,这是模型所熟悉的数字基数。但是,观察他们在十进制上表现良好可能会让我们误以为他们在加法方面能力很强。从逻辑上讲,如果他们真的拥有良好的加法技能,你会期望他们在所有数字基数上都有可靠的高性能,就像计算器或计算机一样。事实上,研究表明,这些模型并不像许多人最初想象的那么强大。它们的高性能仅限于常见的任务变体,并且在不熟悉的反事实场景中会遭受持续而严重的性能下降,表明缺乏可推广的加法能力。

这种模式适用于许多其他任务,如音乐和弦指法、空间推理,甚至是棋子起始位置略有改变的国际象棋问题。虽然人类玩家仍然有望在改变的场景中确定动作的合法性(只要有足够的时间),但这些模型却举步维艰,无法比随机猜测表现更好,这意味着它们在不熟悉的情况下推广的能力有限。而且,它们在标准任务上的表现很可能不是由于一般的任务能力,而是对训练数据中看到的内容进行过度拟合或直接记忆。麻省理工学院电气工程与计算机科学博士生、CSAIL 附属机构、这项研究新论文的

主要作者赵峰吴说:“我们发现了大型语言模型的一个迷人之处:它们在熟悉的场景中表现出色,几乎就像一条人迹罕至的道路,但当地形陌生时就会挣扎。这一见解至关重要,因为我们努力提高这些模型的适应性并拓宽其应用范围。” “随着人工智能在我们社会中变得越来越普遍,它必须可靠地处理各种场景,无论熟悉与否。我们希望这些见解有一天能为未来具有更高稳健性的 LLM 设计提供参考。”

尽管获得了这些见解,但当然也有局限性。该研究侧重于特定任务和设置,并未涵盖模型在实际应用中可能遇到的所有挑战,这表明需要更多样化的测试环境。未来的工作可能涉及扩大任务范围和反事实条件,以发现更多潜在的弱点。这可能意味着研究更复杂和不太常见的场景。该团队还希望通过创建方法来更好地理解模型决策过程背后的原理,从而提高可解释性。

伊利诺伊大学厄巴纳-香槟分校助理教授郝鹏表示:“随着语言模型的扩大,理解它们的训练数据变得越来越具有挑战性,即使对于开放模型也是如此,更不用说专有模型了。社区仍然对这些模型是否真正推广到看不见的任务,或者似乎通过记忆训练数据而取得成功感到困惑。这篇论文在解决这个问题上取得了重要进展。它构建了一套精心设计的反事实评估,为最先进的 LLM 的能力提供了新的见解。它揭示了他们解决看不见的任务的能力可能比许多人预期的要有限得多。它有可能启发未来的研究,以识别当今模型的失败模式并开发更好的模型。”